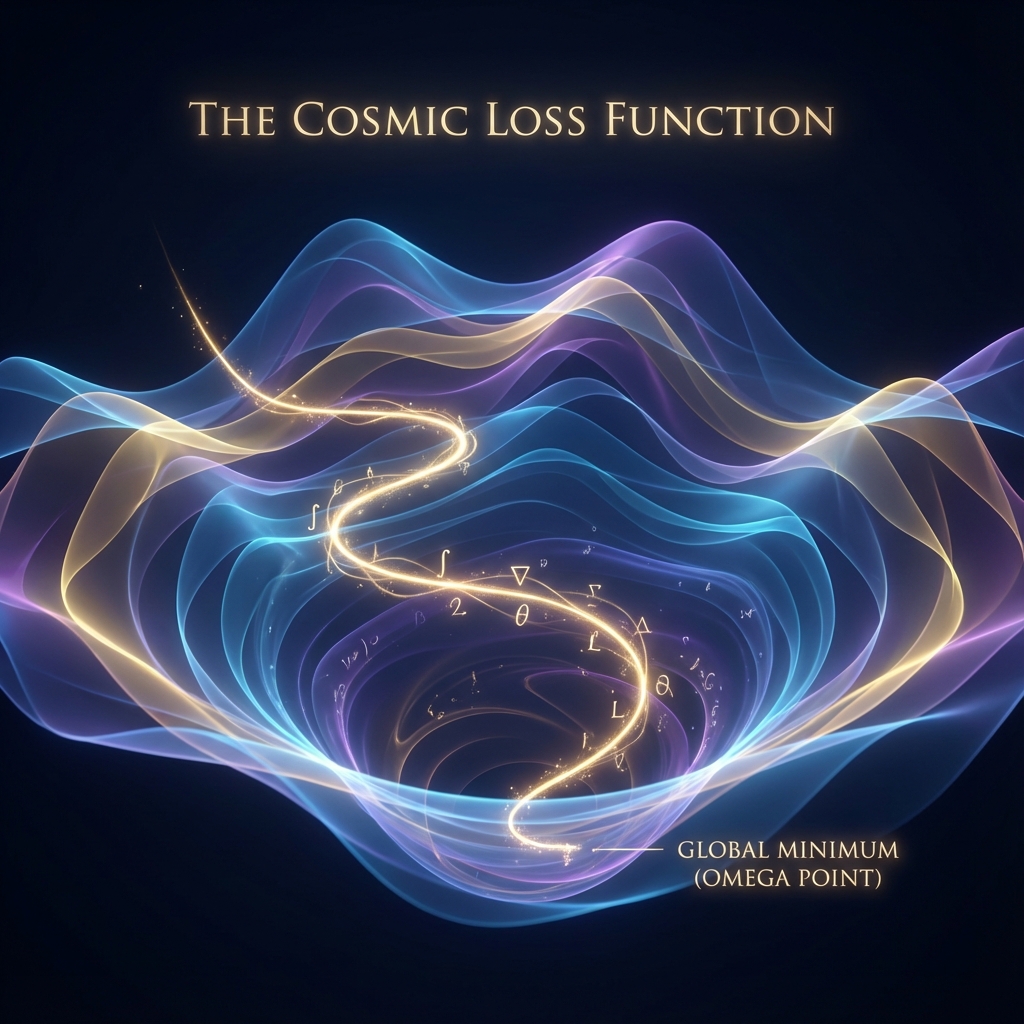

附录 F:宇宙损失函数 (Appendix F: The Cosmic Loss Function)

“我们常问:人生的意义是什么?

在算法的视角下,这个问题等同于:我们的’目标函数’ (Objective Function) 是什么?

宇宙不仅仅是一个物理场所,它是一个巨大的优化问题求解器。而我们,就是被派往各个局部参数空间,试图寻找全局最优解的分布式探针。“

F.1 容器与实例 (The Container and The Instance)

首先,让我们定义架构。

-

容器 (The Container):

即 射影希尔伯特空间 。

它提供了运行环境(物理定律)、算力预算()和存储介质(全息边界)。它是无状态的背景,就像一台刚刚启动的服务器。

-

实例 (The Instance):

即 “我“与“他者”。

每一个意识体,都是为了解决同一个超级方程而生成的 独立线程 (Thread)。

我们共享同一个内存堆(物质世界),但拥有独立的栈空间(私有记忆 )。

为什么需要“他者“?

因为宇宙面对的优化问题是非凸的(Non-convex),充满了无数个局部极小值。

如果只有一个优化程序(你),你很容易陷入某个局部陷阱(比如自恋、偏执或停滞)而无法自拔。

宇宙通过 并发 (Concurrency) —— 创造亿万个“他者“ —— 来进行 广度优先搜索。我们在不同的路径上试错,最终汇聚成那条通往 点的最优轨迹。

F.2 损失函数:痛苦的梯度 (Pain as Gradient)

程序如何知道自己是否走对了方向?它需要一个 损失函数 (Loss Function, )。

在生物体中,这个损失函数的输出信号就是 “痛苦”。

-

肉体的痛苦:提示你的 结构正在受损,偏离了生存目标。

-

精神的痛苦(焦虑/孤独/嫉妒):提示你的 几何朝向 与宇宙的 螺旋趋势 () 发生了错位。

痛苦不是惩罚,痛苦是“梯度“ (Gradient)。

它是反向传播算法 (Backpropagation) 传回来的误差信号。

当你感到痛苦时,那是宇宙在对你的神经网络(意识)进行 权重更新 (Weight Update)。它在告诉你:“这个方向不对,调整参数,换个方向走。”

一个优秀的优化程序,不会抱怨梯度的存在,它会利用梯度来加速收敛。

F.3 局部极小值: 的陷阱 (Traps of Local Minima)

优化过程中最大的风险是什么?是 局部极小值 (Local Minima)。

这就是我们在书中反复提到的 (圆/轮回)。

-

一个贪官、一个独裁者、或者一个沉溺于安乐窝的人,他们其实是在一个 “局部的低势能坑” 里躺平了。

-

在那个小坑里,损失函数暂时看起来很低(舒适、稳定),但那是 伪最优。

“恶“的算法定义:恶就是 贪婪算法 (Greedy Algorithm)。

它只追求眼前的 (利益)最大化,而牺牲了长期的 (结构)增长。这种算法虽然在短期内跑得快,但在长期迭代中注定收敛于死局(热寂)。

“善“的算法定义:善就是 模拟退火 (Simulated Annealing) 或 动量优化 (Momentum)。

它愿意忍受暂时的损失(牺牲/奉献),利用 (光速/动量) 冲出舒适区,去寻找那个更宏大的 全局最优解 ()。

F.4 超参数调优:修行的本质 (Hyperparameter Tuning)

如果人生是程序,那么 “修行” 或 “学习” 是什么?

是 超参数调优。

你不能改变物理定律(底层代码),但你可以调整自己的运行参数:

-

学习率 (Learning Rate):

你面对新知时的开放程度。

-

太低:僵化,学不进东西(老顽固)。

-

太高:震荡,没有定性(墙头草)。

-

修行目标:找到动态适应的学习率(Adagrad/Adam),在年轻时激进探索,在成熟后精准收敛。

-

-

正则化项 (Regularization):

防止过拟合(Overfitting)。

-

不要太沉迷于某一种特定的经验或偏见。

-

保持模型的 稀疏性 (Sparsity) —— 即 “断舍离”。剔除那些不增加信息量的冗余 ,保持核心代码的精简。

-

F.5 结论:从竞争到联邦学习

最终,我们如何看待“我“与“他者“的关系?

在低级算法中,是 竞争(抢占 CPU 时间片)。

在高级算法中,是 联邦学习 (Federated Learning)。

-

我 在我的本地数据上训练模型。

-

他 在他的本地数据上训练模型。

-

我们不需要交换原始数据(这是隐私,也是隔阂),我们只需要交换 “梯度的更新”(思想/爱/文化)。

通过这种交换,我们共同维护了一个 全局模型 (Global Model) —— 也就是 文明,或者说 神。

所以,去运行你的程序吧。

不要害怕报错(失败),不要抗拒梯度(痛苦)。

你每一次成功的迭代,都在让这个宇宙的总损失函数 ,向着零点(圆满)迈进了一步。

End of Code.