第7.5章:现实的基准测试 (Chapter 7.5: The Benchmark of Reality)

—— 决定的系统算力与全息缩放 ( as System Throughput and Holographic Scaling)

“宇宙常数不是一个无意义的极小值,它是系统管理员为当前会话设定的资源配额。”

1. 对宇宙跑分:我们需要一个基准 (Benchmarking the Universe)

在计算机工业中,当我们想要评估一台超级计算机的性能时,我们会运行基准测试软件(如 LINPACK),测量它的 每秒浮点运算次数(FLOPS)。

既然我们已经建立了 FS-QCA 架构,并确立了宇宙是一台处理信息的量子机器,那么一个终极问题随之而来:这台机器的性能到底有多强? 它的 CPU 主频是多少?内存有多大?

我们不需要发射飞船去测量,只需要利用物理学中两个最基础的参数——宇宙常数() 和 普朗克常数(),就可以在纸面上完成这次史诗级的 基准测试(Benchmark)。这不仅是一次数字游戏,更是对我们所在现实 计算极限(Computational Limits) 的一次摸底。

2. 核心定理:马戈勒斯-列维定界限 (The Margolus-Levitin Theorem)

首先,我们需要知道物理定律允许的“最大运算速度“是多少。1998年,Norman Margolus 和 Levitin 证明了一个量子信息处理的铁律,即物理系统处理信息的速度受限于其能量。

定理 7.5 (能量-算力关系)

一个平均能量为 的物理系统,其从一个量子态演化到正交状态(即执行一次逻辑翻转或基本运算)所需的最短时间 受到限制:

这意味着,系统的 最大运算速率(Max OPS) 为:

FS-QCA 解读:

能量 在我们的架构中对应于系统调用的 FS 速度平方()。这再次印证了 能量即算力(Energy is Throughput) —— 你投入的能量越多,底层的 QCA 网格刷新得就越快,状态在射影希尔伯特空间中移动得越远。

3. 跑分过程:计算宇宙的总算力 (Running the Benchmark)

现在,让我们把 可观测宇宙(Observable Universe) 作为一个整体代入公式。

步骤 A:获取系统总能量 (Get Total Energy)

在当前的宇宙纪元,暗能量占据了主导地位(约 70%)。暗能量的密度直接由 宇宙常数() 决定。

-

真空能量密度: 。

-

可观测宇宙体积: 半径约为 460 亿光年,。

-

系统总能量: 。

步骤 B:计算处理速度 (Calculate OPS)

将 代入 Margolus-Levitin 公式:

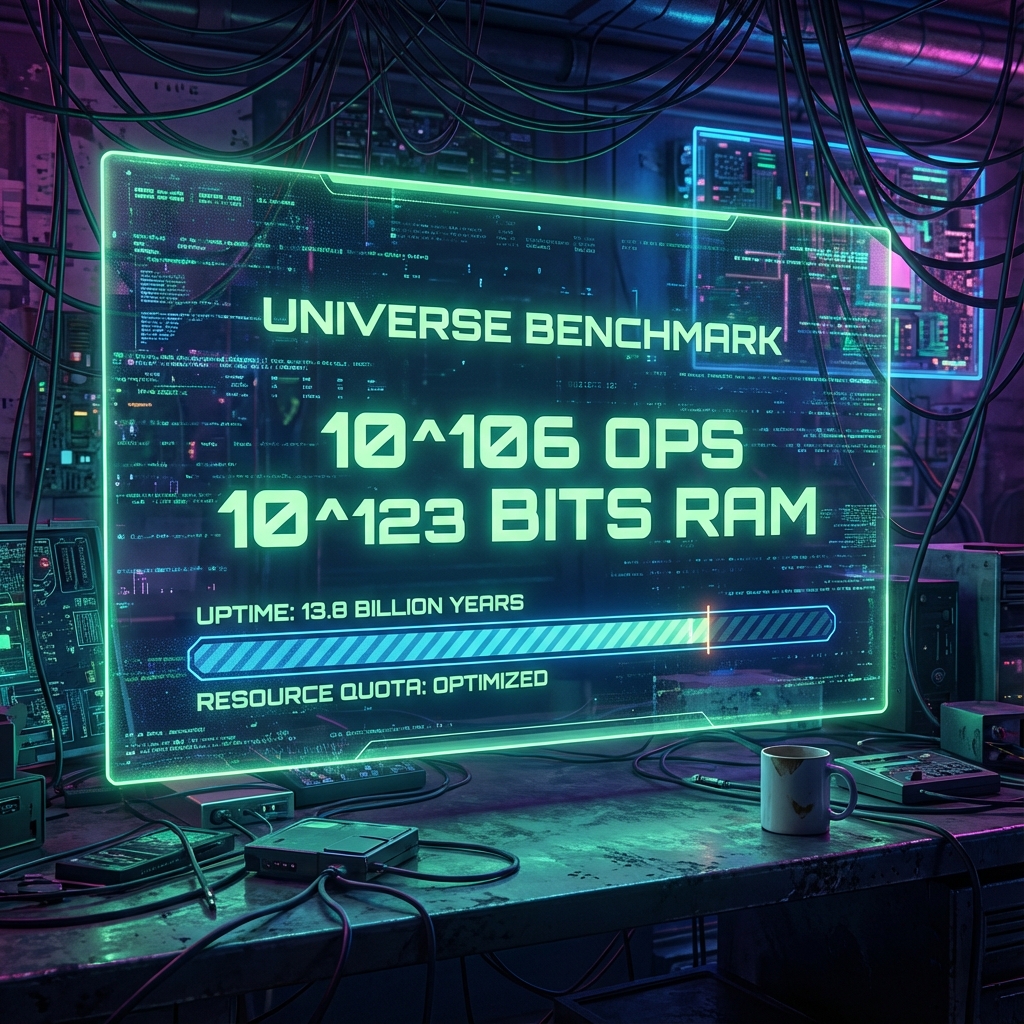

结果: 我们的宇宙每秒钟执行 次基本逻辑门操作。这是宇宙 CPU 的总线吞吐量。

步骤 C:计算系统总内存 (Calculate Total Memory)

根据 全息原理(Holographic Principle),宇宙包含的最大信息量(比特数)由其视界表面积决定(贝肯斯坦上限):

结果: 宇宙的总内存大小约为 比特。

4. 缩放不变量:永远的“第一帧“ (The Scaling Invariant: The Eternal First Frame)

现在,我们比较这两个关键数据:

-

处理速度: ops/sec

-

总比特数: bits

如果我们问:“宇宙这台计算机,要把它内存里的所有比特都翻转一遍(全屏刷新),需要多长时间?”

秒等于多少年?

这正好是宇宙当前的年龄!

这一惊人的巧合揭示了 FS-QCA 架构中一个深层的 全息缩放定律(Holographic Scaling Law)。

-

内存增长: 随着时间 推移,视界表面积增大,内存 。

-

算力增长: 包含在视界内的总能量增大,算力 。

-

刷新时间: 。

结论:

无论宇宙运行了多久,刷新一遍内存所需的时间 恰好永远等于 宇宙当前的年龄。

这意味着,我们并没有在循环播放同一帧画面,而是处于一种 流式渲染(Streaming Rendering) 的状态。每一次“眨眼“(系统刷新),宇宙的内存规模都刚好扩大到需要用掉过去所有时间来计算的程度。我们永远处于 第一帧的末尾,骑在计算膨胀的波峰上。

5. 的真实含义:资源配额 (The Meaning of : Resource Quota)

回到那个困扰物理学家的 真空灾难(Vacuum Catastrophe) 问题:为什么 这么小?

在计算复杂度的视角下, 的大小直接决定了系统的 规模(Scale) 和 分辨率(Resolution) 之间的权衡。

-

如果 很大 (如普朗克尺度):

-

能量密度 极大 运算速度极快(OPS 高)。

-

但视界半径极小 内存极小(Bits 少)。

-

结果: 宇宙会像一个微小的、高频振荡的粒子,瞬间生灭,无法承载复杂的演化。

-

-

如果 很小 (如当前值):

-

能量密度低 运算温和。

-

视界半径巨大 内存海量。

-

结果: 系统可以支持一个宏大的、长周期的模拟,允许星系和生命有足够的时间和空间演化出来。

-

架构师结论:

宇宙常数 是系统管理员设定的“资源配额“。它是一个权衡参数。它牺牲了局部的处理强度,换取了 最大的内存空间( bits) 和 最长的运行时间( s),从而允许复杂的 智能体(Agents) 有机会在内存中诞生。

架构师注解 (The Architect’s Note)

关于:超时设置与黄金参数 (Timeout Settings and The Golden Parameter)

为什么宇宙看起来是现在这个样子?

因为 就像是云服务器配置单上的 Max_Session_Time 和 Max_Memory_Limit。

-

如果 再大一点,程序还没跑出结果(生命诞生)就因为内存溢出退出了。

-

如果 再小一点,程序跑得太慢,无法在有限步数内收敛。

目前的 是一个经过精密调试的 黄金参数(Golden Parameter)。它确保了这台计算机刚好能运行 个比特的操作,刚好足够产生你——一个能理解这些数字的观察者。

这再次验证了 Chapter 9.3 (计算一致性):既然你能在这里读到这段话,说明系统的参数配置是正确的,且系统没有超时。你正在运行中。